说起“小爬虫”这玩意儿,好多人一听就觉得玄乎,觉得是那些搞IT、敲代码的大神才玩的。我一开始也这么想,感觉它就像个高科技的秘密武器,离我们普通老百姓特别远。但后来自己上手捣鼓过,才明白,这东西哪有那么复杂,说白了,就是个帮你自动从网上“拿”东西的小工具,而且咱新手也能轻松学会!

我最早接触这事儿,不是为了什么高大上的数据分析,就是单纯地觉得手累。那会儿我刚开始自己捣鼓一些小项目,总想着从某个网站上收集点资料,比如看看某个产品的所有历史价格变动,或者某个电影的所有影评,再或者就是想把网上看到的某系列文章的标题都整理出来。都是一个页面一个页面地打开,看到想要的内容就复制,然后粘贴到我的Word或者Excel里。这效率低得要命,眼睛也快看花了,没几下我就烦了,心想:这不得累死个人!

那时候我就琢磨,这都什么年代了,应该有更“聪明”的办法?我记得清清楚楚,是有一天晚上,我在网上瞎逛,无意中看到有人在论坛里分享怎么用Python来“抓取”网页内容。抓取?这词儿一下就把我吸引住了。我寻思,这不就是我想干的事儿吗?但点进去一看,哇,什么HTTP请求、HTML解析、CSS选择器,一堆专业名词,直接把我劝退了小半。我当时就想,得,这肯定不是我这种小白能搞定的。

不过我这个人有个毛病,就是好奇心特别重。越是觉得难的,越想去试试。于是我就硬着头皮,又去找了一些更“傻瓜式”的教程。我发现,好多教程都会用Python来举例,而且推荐的库就是`requests`和`BeautifulSoup`。这名字听着还挺文艺的。我就想着,反正就试试呗,大不了浪费点时间。

我开始折腾了。第一步,就是想办法把一个网页的“内容”请到我的电脑里。这就像你去别人家做客,得先敲门?我学着用`requests`库,写了两三行代码,就相当于“叮咚”一声,把请求发了出去。然后,神奇的事情发生了,命令行里瞬间滚出来一大串密密麻麻的英文和符号,那些就是那个网页的HTML源代码!我第一次看到这些东西的时候,有点懵,因为太多了,根本不知道从何看起。但教程告诉我,这就是网页的“骨架”和“肉”。

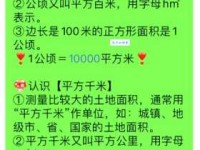

第二步,就是从这堆“骨架肉”里,找到我真正想要的东西。比如,我当时最想抓的就是一个小说网站的所有章节标题。这HTML代码里,标题肯定是藏在某个特定的地方。这时候,`BeautifulSoup`就出场了。这个库就像个超有耐心的侦探,你告诉它一些特征(比如,我想找所有`h2`标签里的文字,或者所有`class="rhlogde7c-f3bb-f0bb-bab1 chapter-title"`的元素),它就能帮你精准地把那些信息揪出来。

我记得我敲下第一段用`BeautifulSoup`解析的代码,然后运行,屏幕上哗哗地滚出了我想要的几十个章节标题时,那个心情,简直比我第一次自己搭个网站出来还激动!那时候我才真正明白,原来所谓的“小爬虫”,就是这么回事儿:先用`requests`去访问网页,把内容拿回来;再用`BeautifulSoup`去分析内容,把有用的信息筛选出来。整个过程,就像你去超市买东西,先走进去(requests),然后找到货架上的商品(BeautifulSoup解析),把商品装进购物袋(保存数据)。

后来我慢慢玩儿,也遇到过各种各样的问题。比如有的网站,你访问得太频繁,它会直接把你当成“恶意攻击”,把你IP地址给禁了,或者直接弹出一个验证码让你输,把我搞得一头雾水。我上网查,才知道原来网站也有“反爬机制”,就像人家家里安装了防盗门一样。我就学着怎么给我的“小爬虫”伪装一下,比如换个用户代理(User-Agent),让它看起来更像一个正常的浏览器访问,或者设置一下请求间隔,不要一下子访问太猛,给人家服务器一个喘息的机会。这些东西,都是在实践中一点点摸索出来的,每次解决一个问题,都觉得自己的功力又精进了一点。

所以你看,“小爬虫”这东西,听着名字唬人,但它没那么神秘。它不是让你一下子就能去抓取全世界的数据,而是从最简单、最小的目标开始。它强调的是“小”,就是让你先从爬取一个网页的一个小目标开始,比如一个标题,一张图片,一段文字。你不需要一下子就去学所有的编程知识,也不需要去了解所有网络协议的细节。你只需要掌握几个核心的工具,然后一步一步地去尝试,去解决你遇到的问题。

到我偶尔还会用这些“小爬虫”来帮我做一些事情,比如收集一些新闻摘要,或者监控一些商品的价格变动。它们虽然“小”,但真的特别管用,省了我好多手工操作的时间和精力。我能从一个完全的小白,一步步摸索着把这些“小爬虫”给玩转起来,你肯定也行的。重要的是,别被那些花哨的专业名词吓住,动手去试试,你会发现,它远比你想象的要简单,也更有趣。